Sobre Autómatos e Linguagens de Programação

Em Autómatos e Linguagens de Programação faz-se uma introdução formal à teoria e às técnicas da análise e definição de linguagens de programação.

Os conceitos e as técnicas tratadas são ilustradas num capítulo final, onde é definida uma linguagem de programação simples e implementado um interpretador para essa linguagem.

Dado um programa python,

# file: guide.py

def resposta():

return 42

print(f"The answer is {resposta()}.\n")

Quando este programa corre, por exemplo

> python guide.py <enter>

> The answer is 42.

o que acontece entre o <enter> na linha python guide.py e aparecer o texto The answer is 42. na consola?

O interpretador do python, entre outras coisas:

- Lê o ficheiro

guide.pydo sistema de ficheiros. - Processa o conteúdo desse ficheiro de forma a determinar se corresponde a um programa válido (em

python, claro). - Executa as instruções desse programa, incluindo:

- A definição da função

resposta()e respetivas “sub-instruções”. - O cálculo do valor da expressão

"The answer is {resposta()}.\n". - Escrever na consola o valor dessa expressão.

- A definição da função

Outro exemplo: uma calculadora “básica”.

Para programar uma calculadora para a linha de comandos, o programa deve receber uma string com uma conta e escrever o respetivo resultado. Por exemplo > calc "2+3*4" deve escrever 14.

Quais são as dificuldades de fazer este programa? Há várias:

- Temos de saber verificar se o input está “bem formado”. Por exemplo

2+3*4está bem, mas+234**nem por isso… - Exatamente, o que “significa” cada “símbolo”?

2é 2? E se aparecer em20? - E como tratar “sequências” de símbolos?

2+3é sempre 2+3? Mas então2+3*4não devia ser14mas20…

Estas são exatamente as questões tratadas em ALP:

- Quais são os símbolos (ou letras) e as palavras válidas (isto é, as sequências de símbolos que sabemos tratar)?

- Como definir e representar todas as palavras válidas, isto é, a linguagem?

- Como distinguir as palavras válidas das inválidas?

- Como atribuir significado às palavras válidas? Isto é, como executar um programa?

Objetivos

Ao completar esta disciplina deve conseguir:

- Discutir máquinas de estados finitos.

- Construir expressões regulares, autómatos e gramáticas para aceitar/gerar linguagens especificadas; Converter entre representações equivalentes.

- Determinar o lugar de uma linguagem na Hierarquia de Chomsky e os principais problemas nas definições da sintaxe de linguagens de programação.

- Usar gramáticas formais para especificar a sintaxe de linguagens, ferramentas declarativas para gerar analisadores e scanners.

- Definir uma semântica formal e uma árvore de sintaxe abstrata para uma linguagem de programação simples.

- Explicar como os programas que processam outros programas tratam os outros programas e as vantagens de ter representações de programas.

- Escrever um programa para processar alguma representação de código.

Programa & Bibliografia

Programa

- Sobre ALP

- Objetivos

- Programa & Bibliografia

- Avaliação

- Palavras, Linguagens e Expressões Regulares

- Alfabetos, Palavras e Linguagens

- Expressões Regulares

- < Exercícios >

- Autómatos Finitos

- Autómatos Finitos Deterministas

- Computação Não-Determinista

- Minimização e Composição de AFD

- O Pumping Lemma

- < Exercícios >

- Gramáticas e Autómatos de Pilha

- Gramáticas Livres de Contexto

- Autómatos de Pilha

- < Exercícios >

- Análise Sintática

- Tipos de Análise Sintática

- Limpeza de uma Gramática

- < Exercícios >

- Gramáticas LL

- < Exercícios >

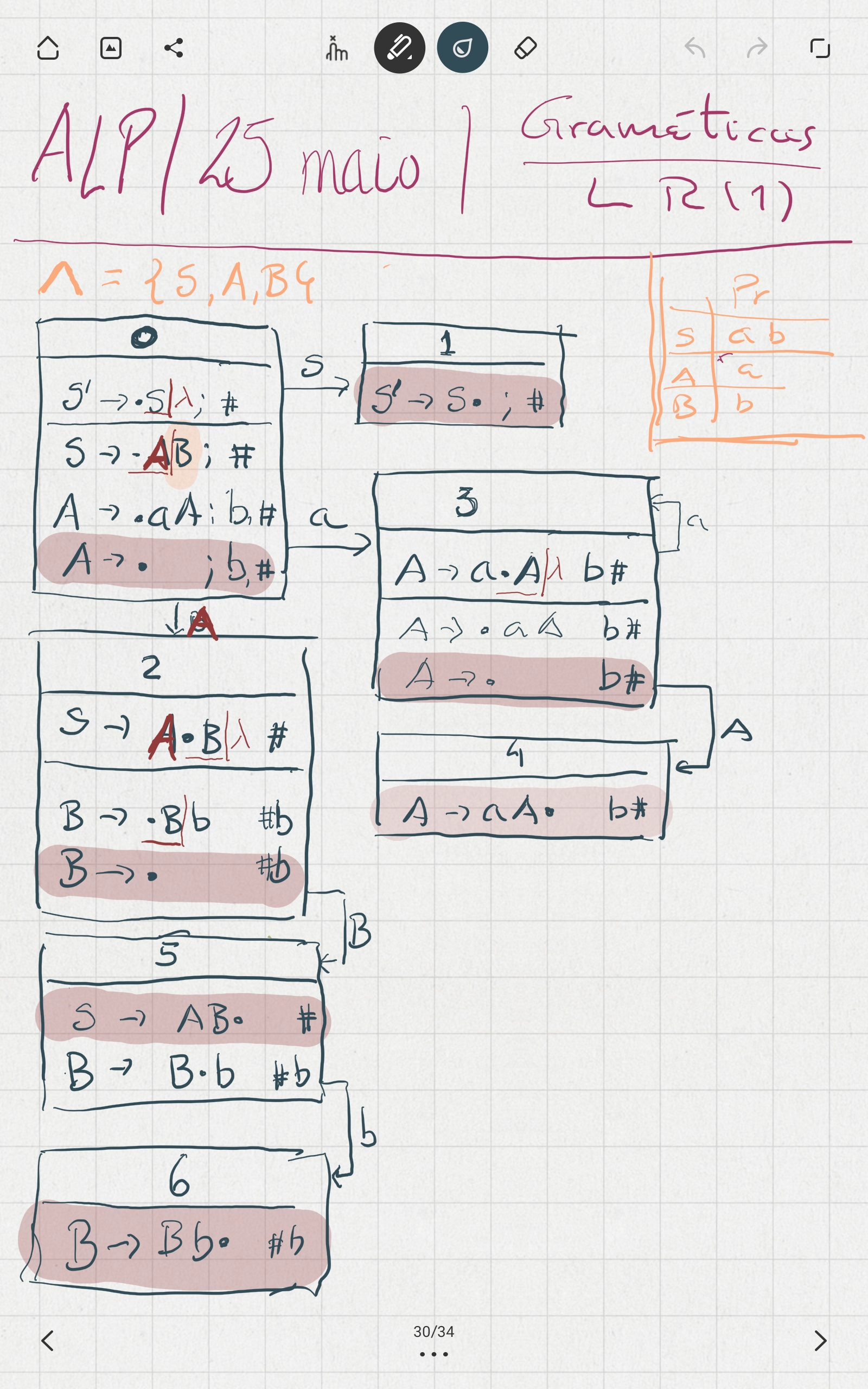

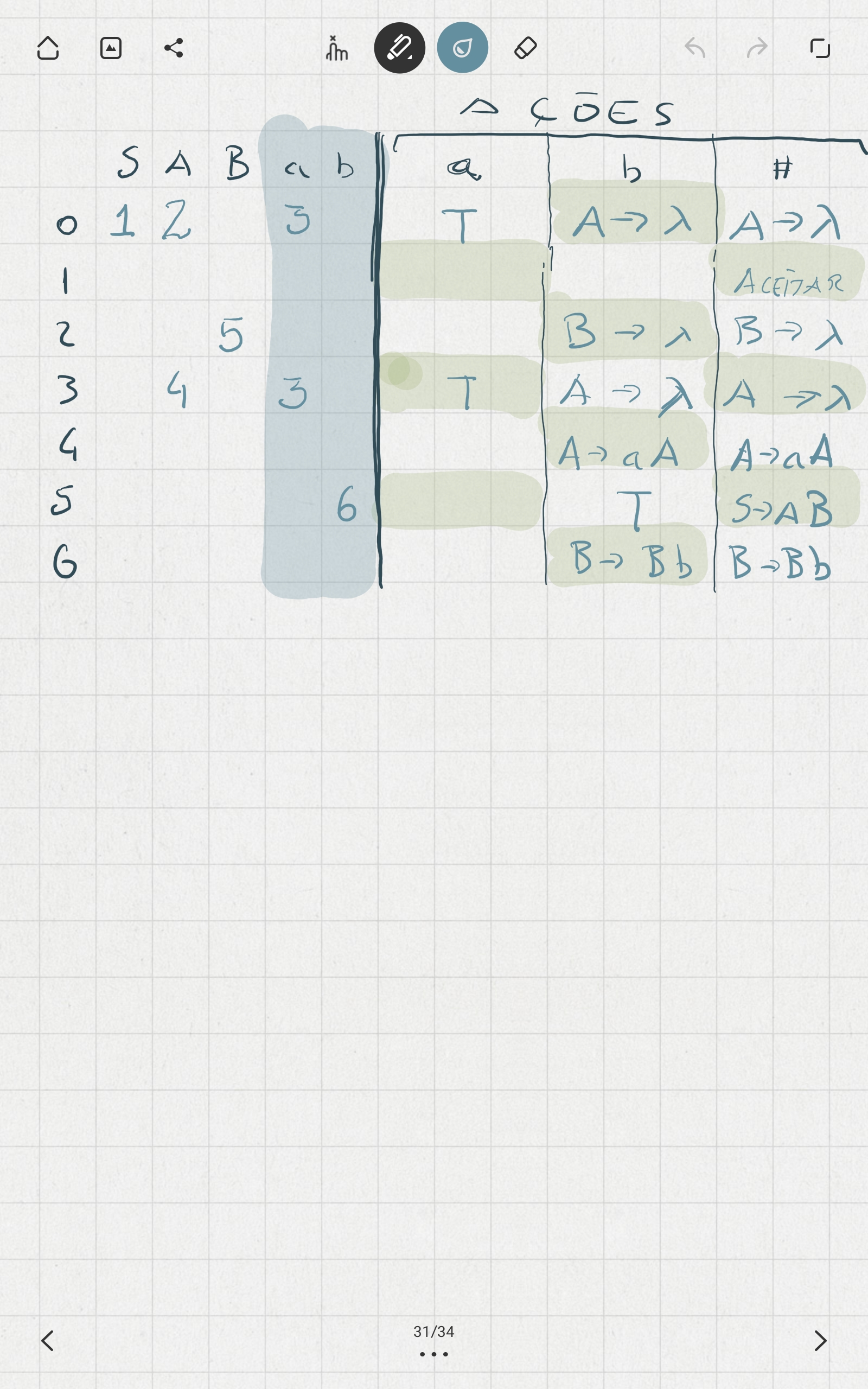

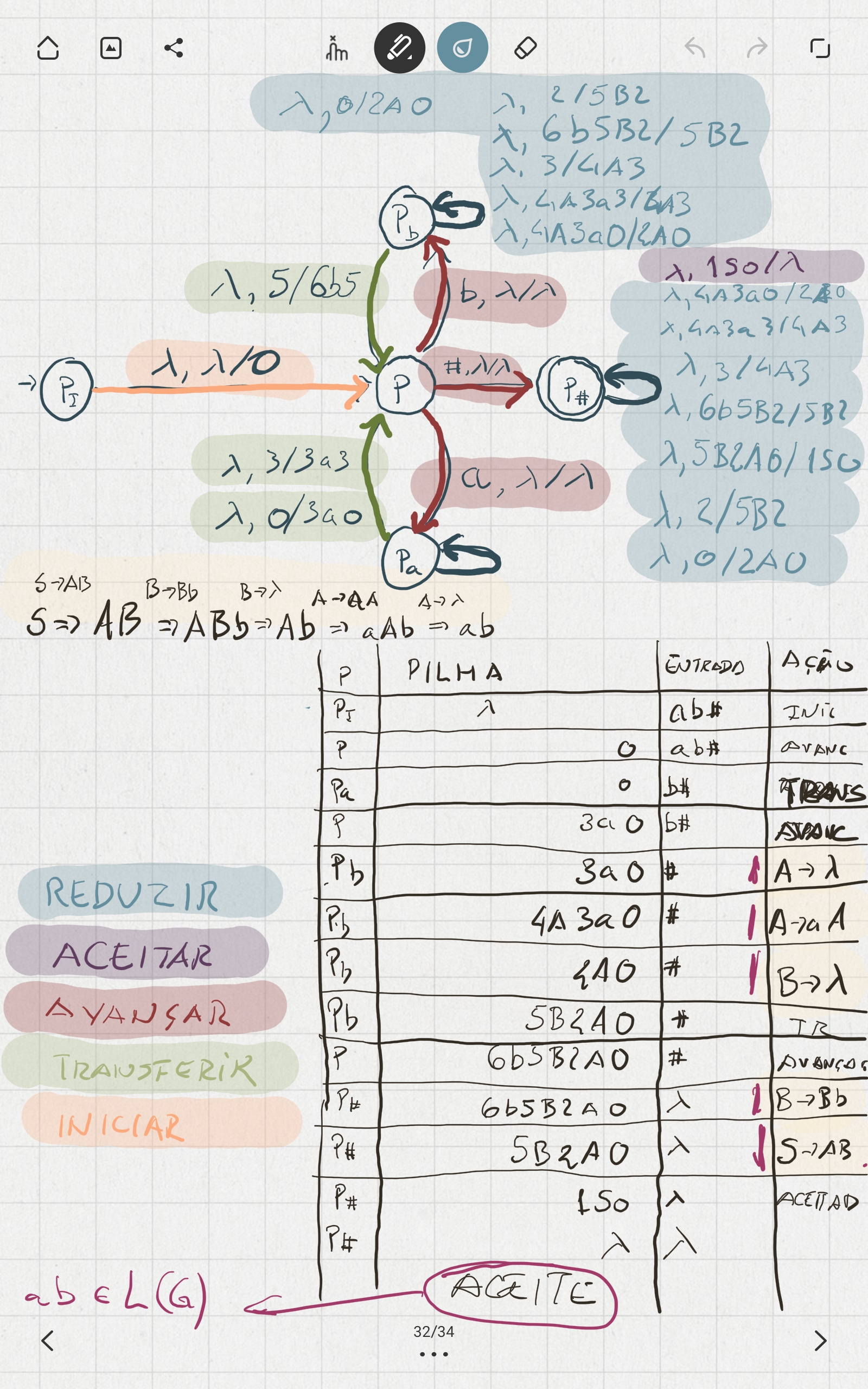

- Gramáticas LR

- < Exercícios >

- Representação & Execução de Programas

- Árvore de Sintaxe Abstrata

- Análise Semântica

- Suporte para um Interpretador

- < Exercícios >

Bibliografia

- Languages and Machines: An Introduction to the Theory of Computer Science, 2 ed. Thomas A. Sudkamp. Addison Wesley, 1997. (320 páginas)

- Compilers: Principles, Techniques and Tools, Alfred V. Aho, Ravi Sethi e Jeffrey D. Ullman. Addison Wesley, 1986. (1038 páginas)

Recursos

- Programação em

python:- Livro: How to Think Like a Computer Scientist: Learning with Python 3 Documentation.

- Tutorial: The Python Tutorial em

python.org. - Cheat Sheets: Várias.

- Simuladores AFD, AFnD, AP, GIC, ER, …

- OFLAT This tool is being developed at NOVA-LINCS (at the Computer Science Department of FCT-UNL) by the projects Factor and LEAFs and co-financed by Tezos Foundation and INRIA Foundation.

- Automata Learning Lab

- JFLAP is software for experimenting with formal languages topics including nondeterministic finite automata, nondeterministic pushdown automata, multi-tape Turing machines, several types of grammars, parsing, and L-systems.

ALisPé uma linguagem de programação usada para exemplificar a matéria de análise sintática.- Palavras Portuguesas (NAO) lista de 431114 palavras portuguesas, uma por linha.

Avaliação

- A avaliação de Autómatos e Linguagens de Programação consiste num exame, ou três frequências.

- As datas das provas são anunciadas no moodle.

- Se reprovar no exame normal pode fazer o exame de recurso.

- Todas as provas são opcionais e sem restrições (por exemplo, nota mínima).

Provas Orais — Em casos individuais que o docente ache necessário, pode ser realizada uma prova oral.

Aviso sobre Plágio ou Fraude

Fraude: Todo o comportamento do estudante em provas ou elementos de avaliação suscetível de desvirtuar o resultado da prova e adotado com a intenção de favorecer intencionalmente o próprio ou terceiros.

-

A fraude ou plágio cometidos em qualquer elemento de avaliação implica a anulação da prova e do seu resultado, sem prejuízo de eventual instauração de procedimento disciplinar.

-

São sanções aplicáveis às infrações disciplinares dos estudantes, de acordo com a sua gravidade:

- A advertência;

- A multa;

- A suspensão temporária das atividades escolares;

- A suspensão da avaliação escolar durante um ano;

- A interdição da frequência da instituição até cinco anos.

Referências

- Regulamento Académico da Universidade de Évora

- Regime jurídico das instituições de ensino superior

- Regulamento Disciplinar dos Estudantes da Universidade de Évora

Palavras, Linguagens e Expressões Regulares

|

|---|

Neste capítulo são fixadas bases rigorosas para a definição de linguagens de programação e a análise dos respetivos programas.

É necessário começar por definir rigorosamente e sem ambiguidades, isto é, matematicamente, certos conceitos fundamentais como “símbolo” (ou “letra”), “palavra” e “linguagem”.

Também são definidas as “expressões regulares”, que permitem representar certas linguagens formais de forma compacta.

Com as “expressões regulares” tem-se uma forma rigorosa de definir certas linguagens formais. É o primeiro passo no processo para representar linguagens de programação.

Alfabetos, Palavras e Linguagens

Era uma vez, num reino muito muito distante, …

Símbolos e Alfabetos

Alfabeto, Símbolo. Um alfabeto é um conjunto finito de símbolos, também designados letras (em inglês: symbols, letters, tokens).

Os alfabetos são normalmente representados por maiúsculas gregas $\Sigma$ (sigma) e $\Gamma$ (gama) e os símbolos por minúsculas romanas $a, b, c, d$.

Por exemplo:

- O alfabeto do português tem os seguintes símbolos: $\tt a, b, c, \ldots, x, y, z$.

- Os símbolos $\tt 0$ e $\tt 1$ formam um alfabeto binário. Outro alfabeto binário muito usado em ALP é $\set{{\tt a}, {\tt b}}$.

- Os números naturais podem ser escritos em base 10 usando o alfabeto $ \set{\tt 0, 1, 2, 3, 4, 5, 6, 7, 8, 9} $.

- Para as expressões algébricas usa-se o alfabeto $ \set{\tt 0, 1, \ldots, 8, 9} \cup \set{\tt +, -, \times, \div, (, )} $.

As linguagens de programação têm um conjunto de palavras reservadas, como

while,if, etc. que são atómicas, isto é, não podem ser divididas.O símbolo “

if” não é, em termos da linguagem de programação, um “i” seguido de um “f”, mas um símbolo que não pode ser decomposto.Já fragmentos de programas como

if (x == 42) { return "yes"; } else { return "no"; }são compostos. Nesta instrução condicional(x == 42)é o teste (ou guarda),{ return "yes"; }o bloco positivo e{ return "no"; }o bloco negativo. Neste caso a instrução resulta de uma regra do tipo

Condicional := if ( Condição ) { Instruções } else { Instruções }Por sua vez a guarda (

Condição) e os blocos deInstruçõespodem ser decompostos, até chegarmos a símbolos atómicos como(,==,return, etc.

Palavras

Palavra. Uma palavra sobre um alfabeto $\Sigma$ é uma sequência finita de símbolos desse alfabeto (em inglês: word).

Formalmente, uma palavra de comprimento $n$ é uma função $p: \set{1, 2 \ldots, n} \to \Sigma$ que a cada inteiro $i \in \set{1, 2, \ldots, n} \mapsto p(i) \in \Sigma$.

As palavras são normalmente representadas pelas minúsculas romanas $p, q, u, v, w, x, y, z$.

Palavra Vazia. A palavra vazia (em inglês: empty word, null, nil) é a única palavra de comprimento 0 e representa-se pela letra grega $\nil$ (lambda). Também é comum usar-se $\epsilon$ ou $\varepsilon$ (epsilon) para representar a palavra vazia.

Não confundir a palavra $\nil$ (que tem comprimento 0) com um símbolo. Estes, como palavras, têm comprimento um.

Propriedades do Comprimento das palavras

- O comprimento da palavra $p$ é normalmente representado por $|p|$.

- Para a palavra vazia, $|\nil| = 0$. Em geral, se $p = a_1 \cdots a_n$ então $|p| = n$. Isto é, $|a_1\cdots a_n| = n$.

Fecho de Kleene

Dado um alfabeto, interessa considerar todas as palavras que podem ser formadas com essas letras.

Por exemplo, para representar números em binário usam-se palavras sobre $\set{\tt 0, 1}$. Mas, depois de se definirem todas as palavras, há que determinar quais as que interessam. Por exemplo, embora $\tt 00$ e $\tt 0$ sejam palavras binárias (distintas), se interpretadas normalmente, ambas correspondem ao número $0$ e portanto há aqui uma ambiguidade. Será possível definir uma linguagem que continue a representar todos os números mas sem ambiguidades?

Para abordar estas questões tem de se começar por definir rigorosamente o conjunto de todas as palavras que se podem obter com um dado alfabeto.

Fecho de Kleene. O fecho do alfabeto $\Sigma$ é o conjunto de todas as palavras sobre $\Sigma$, representa-se por $\Sigma^\ast$ e fica definido pelas seguintes condições:

- base $\nil \in \Sigma^\ast$.

- passo Se $p \in \Sigma^\ast$ e $a \in \Sigma$ então $pa \in \Sigma^\ast$.

- fecho Qualquer palavra $p \in \Sigma^\ast$ só pode ser obtida por um número finito de aplicações do passo a começar na palavra vazia. E reciprocamente, qualquer palavra obtida a partir de $\nil$ por aplicações do passo em número finito está em $\Sigma^\ast$.

Esta definição exclui a possibilidade de palavras infinitas. Mas isto não significa que exista um limite ao comprimento das palavras em $\Sigma^\ast$. Pelo contrário, se $\Sigma \neq \emptyset$ então, para qualquer $n \in \mathbb{N}$ existe pelo menos uma palavra de comprimento $n$.

Exercício: Porquê? E porque é que acima é referida a condição “$\Sigma \neq \emptyset$”? O que é $\emptyset^\ast$?

No fecho de um alfabeto também ficam excluídas palavras formadas por símbolos de outros alfabetos. Por exemplo, a palavra $\tt abc$ não está em $\cl{\set{\tt a, b}}$.

Logo a primeira condição na definição de $\Sigma^\ast$ inclui a palavra vazia. Como muitas vezes é conveniente excluir $\nil$ define-se $$ \Sigma^+ = \cup_{n > 0} \Sigma^n = \Sigma \Sigma^\ast. $$

Exercício: Mostre que $\Sigma^+ = \Sigma^\ast \setminus \set{\nil}$.

Operações com Palavras

Comprimento

Ainda não foi apresentada uma definição rigorosa de comprimento de uma palavra. Usando um esquema recursivo:

Comprimento. A função comprimento é calculada pelas seguintes regras:

- base $|\nil| = 0$.

- passo $|pa| = |p| + 1$, com $p \in \Sigma^\ast, a \in \Sigma$.

Por exemplo, para calcular $\len{\tt abc}$:

- Como ${\tt abc}\ \neq\ \nil$, aplicar-se a regra do passo: fazendo $pa = {\tt abd}$ tem de ser $p = {\tt ab}$ e $a = {\tt c}$, e obtem-se $\len{\tt abc} = \len{\tt ab} + 1$.

- Ainda não está calculado o valor de $\len{\tt ab}$. Tornando a aplicar o passo: $\len{\tt ab} = \len{\tt a} + 1$.

- Uma nova aplicação do passo: $\len{\tt a} = \len{\nil} + 1$.

- Finalmente, pela base: $\len{\nil} = 0$, portanto $\len{\tt a} = 0 + 1 = 1$ e, sucessivamente, obtém-se $\len{\tt ab} = 2$ e $\len{\tt abc} = 3$.

Também é comum usar-se a notação $\len{p}_a$ para indicar o número de ocorrências do símbolo $a$ na palavra $p$.

Por exemplo: $\len{\tt aba}_{\tt a} = 2, \len{\tt aba}_{\tt b} = 1$.

Concatenação

O operação fundamental das palavras é a “concatenação”. A concatenação de hello com world é helloworld. Para definir rigorosamente esta operação:

Concatenação. A concatenação (ou produto) de duas palavras $u, v \in \Sigma^\ast$ representa-se por $u\cdot v$ ou apenas $uv$ e é uma operação binária definida por:

- base Se $v = \nil$ então $u\cdot v= u$.

- passo Se $|v| = n > 0$ então

- Existe uma palavra $w \in \Sigma^\ast$ e uma letra $a \in \Sigma$ tal que $v = wa$.

- $u\cdot v = (u\cdot w)a$.

Por exemplo, para calcular a concatenação de $\tt ab$ com $\tt cd$:

- O comprimento de $\tt cd$ é 2, portanto temos de aplicar o passo: ${\tt ab}\cdot{\tt cd} = ({\tt ab}\cdot {\tt c}){\tt d}$.

- Precisamos de calcular ${\tt ab}\cdot {\tt c}$. Pela regra do passo: ${\tt ab}\cdot {\tt c} = ({\tt ab}\cdot \nil) {\tt c}$.

- Finalmente, ${\tt ab}\cdot \nil$ é calculada pela regra base: ${\tt ab}\cdot \nil = {\tt ab}$.

- Andando para trás: ${\tt ab}\cdot {\tt c} = ({\tt ab}\cdot\nil){\tt c} = ({\tt ab}){\tt c} = {\tt abc}$ e, portanto, ${\tt ab}\cdot{\tt cd} = ({\tt ab}\cdot{\tt c}){\tt d} = {\tt abcd}$.

Potência

A repetição de concatenações define as potências, tal como a multiplicação dos números.

Potências. As potências da palavra $p \in \Sigma^\ast$ são (informalmente): $$ p^0 = \nil, p^1 = p, p^2 = pp, \ldots, p^n = p^{n-1}p. $$

Por exemplo, $({\tt 01})^2 = {\tt 0101}$ mas ${\tt 01}^2 = {\tt 011}$, seguindo as regras normais de precedência das operações.

Inversa

Finalmente, as palavras (enquanto sequências de símbolos) podem ser escritas “de trás para a frente”:

Inversa. A inversa de $p \in \Sigma^\ast$, representada por $p^R$ (ou $p^{-1}$) é calculada pelas seguintes regras:

- base Se $p = \nil$ então $p^R = p$.

- passo Se $|p| = n > 0$ então $p = qa, a \in \Sigma$ e $p^R = a q^R$.

Por exemplo, se $p = {\tt abcd}$ então $p^R = {\tt dcba}$.

Propriedades das Operações de Palavras

O que acontece à inversa de duas palavras concatenadas?

Para quaisquer palavras $u, v \in \cl{\Sigma}$, $$ (uv)^R = v^R u^R$$

Demonstração (informal): Se $u=\nil$ a conclusão é evidente. Caso contrário $u = u_1 u_2 \ldots u_n$ e $v = v_1 v_2 \ldots v_m$ com todos os $u_i, v_j \in \Sigma$. Então: $$ \begin{aligned} (uv)^R &= (u_1 u_2 \ldots u_n v_1 v_2 \ldots v_m)^R \cr &= v_m \ldots v_2 v_1 u_n \ldots u_2 u_1 \cr &= (v_m \ldots v_2 v_1)(u_n \ldots u_2 u_1) \cr &= v^R u^R\qquad\qquad\square \end{aligned} $$

O fecho também tem propriedades interessantes.

Se $\Sigma, \Gamma$ forem alfabetos,

- $\cl{\Sigma} = \cup_{n \geq 0} \Sigma^n$.

- $\Sigma \subseteq \cl{\Sigma}$.

- $\cl{\emptyset} = \set{\nil}$.

- Se $\Sigma \neq \emptyset$ então $\cl{\Sigma}$ é infinito.

- Se $\Sigma \subset \Gamma$ então $\cl{\Sigma} \subset \cl{\Gamma}$.

Por fim, a concatenação tem propriedades semelhantes às do produto (de números).

Sejam $u, v, w \in \cl{\Sigma}$.

- associativa $u(vw) = (uv)w$.

- elemento neutro $u\nil = \nil u = u$.

- não comutativa Em geral, $uv \neq vu$.

- aditiva $\len{uv} = \len{u} + \len{v}$.

- unicidade Cada palavra só pode ser escrita de uma única forma como concatenação de símbolos. Isto é, se $u = v$ e $u = u_1 \ldots u_n$ e $v = v_1 \ldots v_m$ então $n = m$ (mesmo comprimento) e $u_i = v_i$ para cada $i =1, \ldots, n$ (mesmos símbolos) .

Ordenações de Palavras

Uma palavra pode “conter” outra. Por exemplo, palavra contém pala no início, ala no “meio” e lavra no fim. Estes três casos ilustram as definições que se seguem:

Subpalavra, prefixo, sufixo. Sejam $p, q, u, v \in \cl{\Sigma}$.

- subpalavra $p \leq q$ se $q = upv$.

- prefixo $p \leq_P q$ se $q = pv$.

- sufixo $p \leq_S q$ se $q = up$.

Fica claro que os prefixos são casos particulares das subpalavras (quando $u = \nil$) e que cada palavra é subpalavra de si própria (quando $u = \nil = v$).

Outro caso importante é a ordem lexicográfica (dos dicionários), onde se usa a ordem das letras para ordenar as palavras.

Ordem Lexicográfica. Supondo que o alfabeto está ordenado, $\Sigma = \set{a_1 < a_2 < \cdots < a_n}$. Então $p \leq_L q$ se:

- $p \leq_P q$.

- Caso contrário, $p = us_iv$ e $q = us_jw$ com $s_i < s_j$.

Esta definição abrange dois casos:

por < porqueporqueporé um prefixo deporque.porque < portugalporque, comoporque = por_q_ueeportugal = por_t_ugalentãoportugaleporquetêm um prefixo comum,por, e “divergem primeiro” nas letrasqet. Comoq < tentãoporque < portugal.

A ordem lexicográfica tem um problema interessante: Quantas palavras existem entre $\tt 0$ e $\tt 1$, num alfabeto binário?

Por exemplo ${\tt 00} <_L {\tt 1}$ [Exercício: porquê?]. Mas também ${\tt 000} < {\tt 1}$. De facto, ${\tt 0}^n < {\tt 1}$ para qualquer $n > 0$. Portanto, seguindo a ordem lexicográfica, há infinitas palavras entre $\tt 0$ e $\tt 1$.

Esta conclusão, embora dramática, mostra que a ordem lexicográfica é inútil na importante tarefa de enumerar (isto é, listar) todas as palavras por ordem. Para resolver este problema é necessária mais uma ordem entre palavras:

Ordem Mista. Dadas duas palavras $p, q \in \cl{\Sigma}$, $p \leq_M q$ se $\len{p} < \len{q}$ ou ($\len{p} = \len{q}$ e $p \leq_L q$).

Dito de outra forma, a ordem mista define o seguinte processo:

- Primeiro, as palavras são agrupadas por comprimentos iguais: todas as palavras de comprimento 0 antes das de comprimento 1, todas as de comprimento 1 antes das de 2, etc.

- Depois, em cada grupo, as palavras (todas com o mesmo comprimento) são ordenadas lexicograficamente.

Revisitando o exemplo anterior:

- $\tt 0$ e $\tt 1$ têm o mesmo comprimento. Portanto, são comparadas lexicograficamente: ${\tt 0} <_M {\tt 1}$ porque ${\tt 0} <_L {\tt 1}$ .

- O comprimento de $\tt 00$ é maior que o de $\tt 1$. Portanto, ${\tt 1} <_M {\tt 00}$.

- $\tt 01$ e $\tt 10$ têm o mesmo comprimento. Lexicograficamente, ${\tt 01} <_L {\tt 10}$ portanto ${\tt 01} <_M {\tt 10}$.

De facto a ordem mista é uma ferramenta essencial porque permite “avançar passo-a-passo” no conjunto de todas as palavras, sem deixar nenhuma de fora. Mais concretamente:

A ordem mista define uma sequência de todas as palavras. No caso do alfabeto binário, com $\tt 0 < 1$:

$$ \nil <_M {\tt 0} <_M {\tt 1} <_M {\tt 00} <_M {\tt 01} <_M {\tt 10} <_M {\tt 11} <_M {\tt 000} <_M \cdots $$

Sucessor

A ordem mista permite começar na primeira palavra, avançar para a seguinte, depois para a seguinte, etc. da mesma forma são contados os números: 0, 1, 2, etc.

A passagem de um número para o seguinte (x++) tem nome, sucessor, que também se aplica às palavras:

Sucessor. Seja $\Sigma = \set{a_1 < a_2 < \cdots < a_n}$ um alfabeto ordenado. A função sucessor tem assinatura $\sigma: \cl{\Sigma} \to \cl{\Sigma}$ e calcula-se pelas seguintes regras:

- base $\sigma(\nil) = a_1$.

- passo Se $i < n$ então $\sigma(pa_i) = pa_{i + 1}$. Caso contrário, $\sigma(pa_n) = \sigma(p)a_1$.

Voltando ao exemplo anterior: $$ \sigma(\nil) = {\tt 0}, \sigma({\tt 0}) = {\tt 1}, \sigma({\tt 1}) = \sigma(\nil){\tt 0} = {\tt 00}, \ldots $$

Visto de outra forma, usando o sucessor obtém-se uma sequência que começa na palavra vazia e percorre todas as palavras:

$$ \nil \stackrel{\sigma}{\rightarrow} {\tt 0} \stackrel{\sigma}{\rightarrow} {\tt 1} \stackrel{\sigma}{\rightarrow} {\tt 00} \stackrel{\sigma}{\rightarrow} \cdots $$

Há uma clara relação entre a ordem mista e a função sucessor.

Seja $p_0 <_M p_1 <_M p_2 <_M \ldots$ a sequência de todas as palavras de $\cl{\Sigma}$ que se obtém com a ordem mista e $p \in \cl{\Sigma}$ uma palavra qualquer.

- $p <_M \sigma(p)$.

- Se $p \neq \nil$ então existe uma palavra $q\in\cl{\Sigma}$ tal que $p = \sigma(q)$.

- $p_{i+1} = \sigma(p_i)$.

O que este teorema afirma, especialmente na igualdade $p_{i+1} = \sigma(p_i)$, é que a ordem mista e a função sucessor são aspetos diferentes da mesma enumeração das palavras.

Linguagens

Numa linguagem de programação nem todas as palavras possíveis correspondem a programas válidos. Por exemplo:

2 return) *

: dobro def (x

é uma palavra que pode ser formada com o alfabeto do python, mas não é um programa.

É necessário, de alguma forma, distinguir as palavras que são “válidas” das outras que não o são. De novo, encontramos na matemática exatamente as ferramentas necessárias.

Linguagem. Uma linguagem é um conjunto de palavras sobre um certo alfabeto. Isto é, $A$ é uma linguagem sobre $\Sigma$ se $A \subseteq \cl{\Sigma}$.

Esta definição de linguagem parece dizer pouco, mas por enquanto serve exatamente para o que se pretende.

Por exemplo, se $\Pi$ for a linguagem dos programas python então ${\tt print(2 + 40)} \in \Pi$ mas ${\tt +)\ 40 print\ 2\ (} \not \in \Pi$.

Mais tarde será enunciado e tratado o Problema Principal de ALP:

Problema Principal de ALP (versão 0). Dada uma linguagem $A$ e uma palavra $p$ no mesmo alfabeto, determinar se $p \in A$.

Entretanto, como uma linguagem é (apenas) um conjunto de palavras, tem um certo número de elementos, que pode ser infinito (quantos programas python existem?): Se $A$ for uma linguagem, $\len{A}$ representa o número de elementos de $A$.

Outros exemplos de linguagens são:

- binárias $\set{\tt 0, 1}$, $\set{\tt \nil, 0, 00, 000, \ldots}$, etc.

- As palavras do português, sobre o alfabeto romano. Por exemplo,

a,aba,abade, etc. mas nãoaa,prof,tásse,xkcd, etc. - Os programas de uma linguagem de programação.

- As frases do português, sobre o alfabeto formado pelas palavras do português. Por exemplo

bom dia,a aula é longa, etc. mas nãodia dia dia,aula a é longa, etc.

Muitas vezes é útil visualizar-se uma linguagem de forma a explorar a estrutura das suas palavras. Isso pode ser feito através de árvores:

Árvore de uma Linguagem. Seja $A \subseteq \cl{\Sigma}$ uma linguagem sobre $\Sigma$.

Os vértices (ou nós) da árvore de $A$ (ou diagrama de $A$) são palavras de $\cl{\Sigma}$ e cada aresta (ou arco) tem um símbolo de $\Sigma$. Além disso, todas as arestas são da seguinte forma: se $p\in\cl{\Sigma}$ e $a \in \Sigma$ então $p \stackrel{a}{\rightarrow} pa$ é uma aresta. A raíz da árvore é a palavra vazia.

Cada vértice é representado por um círculo com a respetiva palavra lá dentro. Uma palavra da linguagem $A$ é representada por um círculo duplo.

Por exemplo, $A = \set{\tt 01, 011, 11, 101} \subseteq \cl{\set{\tt 0, 1}}$ tem a seguinte árvore (onde os vértices irrelevantes foram omitidos):

| Árvore (parcial) de $A = \set{\tt 01, 011, 11, 101}$ |

|---|

|

| As palavras de $A$ estão em círculos duplos. |

Operações com Linguagens

Como conjuntos, as linguagens podem ser combinadas pelas operações comuns: união, intersecção, etc. Além disso, como os seus elementos são palavras, podem ser definidas operações adicionais, específicas das linguagens (concatenação, fecho, etc).

Operações com Linguagens. Sejam $A, B$ linguagens sobre $\Sigma$. Estão definidas as seguintes operações de conjuntos:

- união $A \cup B = \set{p: p \in A \lor p \in B}$.

- intersecção $A \cap B = \set{p: p \in A \land p \in B}$.

- subtração $A \setminus B = \set{p: p \in A \land p \not\in B}$.

- complemento $\overline{A} = \cl{\Sigma} \setminus A$.

Adicionalmente, usando as operações de palavras:

- concatenação $A B = \set{pq: p \in A \land q \in B}$.

- potências $A^0 = \set{\nil},\ A^1 = A,\ A^2 = AA,\ \ldots,\ A^{n+1} = A A^n$.

- fechos $\cl{A} = A^0 \cup A^1 \cup A^2 \cup \cdots,\ A^+ = A\cl{A}$.

- inversão $A^R = \set{p^R: p \in A}$.

Alguns exemplos das operações específicas das linguagens: Sejam $A = \set{\tt a, b, ac}, B= \set{\tt \nil, a, c}$. Então:

- $AB = \set{\tt a, b, ac}\set{\tt \nil, a, c} = \set{\tt a\nil, aa, ac, b\nil, ba, bc, ac\nil, aca, acc} = \set{\tt a, aa, ac, b, ba, bc, aca, acc}$.

- As palavras de $AB$ foram formadas escolhendo primeiro uma palavra de $A$ e depois uma palavra de $B$.

- A palavra $\tt ac$ pode ser obtida de suas formas: $\tt a \cdot c$ e $\tt \nil \cdot ac$.

- $B^2 = BB = \set{\tt \nil, a, c}\set{\tt \nil, a, c} = \set{\tt \nil, a, c, aa, ac, ca, cc}$.

- $A^0 = \set{\nil}; A^2 = \set{\tt aa, ab, aac, ba, bb, bac, aca, acb, acac}, \ldots$.

- $A^R = \set{\tt a, b, ca},\ B^R=\set{\tt \nil, a, c} = B$.

Confusões com a palavra vazia, o conjunto vazio, etc.

- A palavra vazia, $\nil$, não é um símbolo. Qualquer símbolo, como palavra, tem comprimento 1. A palavra vazia tem comprimento 0.

- O conjunto vazio, $\emptyset$, tem 0 elementos. Para tornar este facto mais explícito também se escreve $\emptyset = \set{}$.

- O conjunto $\set{\nil}$ tem um elemento, $\nil$. Portanto, não é o conjunto vazio.

Exemplo. Aqui (e só no âmbito deste exemplo) estamos a distinguir explicitamente os símbolos usando plicas, como em 'a', e as palavras usando aspas, como em "ab".

- O alfabeto

{a, b}tem dois símbolos:'a'e'b'. - Uma palavra é uma (qualquer) sequência finita de símbolos.

- Por exemplo

"abba","baba","aa", etc.

- Por exemplo

- Todas as palavras de comprimento 2 são

"aa","ab","ba","bb". - Também poderíamos listar todas as palavras de comprimento 3 (num total de oito palavras), etc.

- Todas as palavras de comprimento 1 são

"a"e"b".- Se quiséssemos ser terrivelmente rigorosos, teríamos de dizer que

'a'e"a"são diferentes porque'a'é um símbolo e"a"é uma sequência de símbolos, tal como, por exemplo, o inteiro1é completamente diferente de[1], que é uma lista de inteiros. - Raramente é necessário distinguir explicitamente os símbolos das palavras de comprimento um.

- Se quiséssemos ser terrivelmente rigorosos, teríamos de dizer que

- Só há uma palavra com comprimento zero. Como sequência,

""é a (única) com zero símbolos. Em vez de""escreve-seλ(ouεouϵ).λnão é um símbolo mas uma palavra. Escrita por extenso é"".

- Usando a concatenação de palavras podemos escrever, por exemplo:

"abba" = "ab" · "ba".- Outras formas de obter

"abba"são"abba" = "a" · "bba","abba" = "abb" · "a", etc. - Em particular também

"abba" = "abba" · λou"abba" = λ · "abba"ou mesmo"abba" = λ · "a" · λ · "bba". - Nestes exemplos o

λnunca aparece entre"..."pois isso é o equivalente a um erro sintático. Também não escrevemos2 */ 3quando fazemos contas…

- Outras formas de obter

- Em geral não se escrevem os símbolos como

'a', as palavras como"abab"nem as concatenações como"aa" · "ba".- Portanto, em vez de

"abba" = λ · "a" · λ · "bba"o que escrevemos é simplesmenteabba = λaλbba. - Este abuso de notação pode facilitar a leitura errada de

λcomo um símbolo, à semelhança deaeb.

- Portanto, em vez de

Linguagens e Expressões Regulares

Uma forma de especificar linguagens formalmente.

Na secção anterior observou-se que para definir uma linguagem de programação o fecho, $\cl{\Sigma}$, não é adequado porque tem “demasiadas” palavras.

Mais precisamente, a situação é a seguinte:

Para definir uma linguagem de programação começa-se for escolher um certo alfabeto e, sobre esse alfabeto, define-se uma linguagem cujas palavras são exatamente os programas válidos da linguagem de programação.

O Problema Principal de ALP (versão 0) – Dada uma linguagem $A$ e uma palavra $p$ no mesmo alfabeto, determinar se $p \in A$ – não desenvolve condições para determinar $p \in A$. É necessário um “sistema” que permita definir linguagens formais e que seja:

- Computável: Existe um algoritmo que recebe como entrada uma palavra $p$ e ao fim de um número finito de passos produz uma resposta

simounãoconforme $p \in A$ ou não. - Eficiente: O número de passos referido no passo anterior não deve ser “muito maior” que o comprimento da palavra.

- Adequado: Deve ser possível definir (os programas de) qualquer linguagem de programação.

Portanto:

Problema Principal de ALP (versão 1): Determinar um sistema computável e eficiente para determinar se $p \in A$ e que seja adequado (i.e., $A$ é uma linguagem de programação).

Linguagens Regulares

As operações entre linguagens (principalmente, a união, a concatenação e o fecho) permitem começar por linguagens muito simples e definir formalmente, rigorosamente, sem ambiguidades, linguagens mais complexas. Por exemplo, a partir do alfabeto binário $\set{\tt 0, 1}$, a linguagem das palavras com um número par de $\tt 1$ é $\cl{\set{\tt 0, 11}}$.

O ênfase em “formal, rigoroso, não ambíguo” é necessário para resolver algoritmicamente o Problema Principal de ALP. Mais especificamente, pretende-se obter um programa que tem como entrada uma especificação formal de uma linguagem e que produz um segundo programa que tem como entrada uma palavra e que determina se essa palavra pertence, ou não, à linguagem dada ao primeiro programa. Isto é, pretende-se definir um programa Super tal que

- Se

efor uma especificação formal de uma linguagem de programaçãoL:PL = Super(e). - Seja

puma palavra.PL(p)éverdadeoufalsoconformep in Lou não. - Tanto

SuperquantoPLdevem ser eficientes.

O Problema Principal de ALP, nas suas várias versões, trata de encontrar uma “especificação formal” adequada e obter os programas Super e PL. De facto, a resolução seguida em ALP até vai mais longe: A resposta a $p \in A$ é calculada de forma que quando $p$ for um programa válido (isto é, “$p \in A$” é verdade) também se obtém uma “representação intermédia” de $p$, apta a ser executada.

Por enquanto define-se a classe das linguagens regulares:

Linguagem Regular (LR). Seja $\Sigma$ um alfabeto. Uma linguagem regular sobre $\Sigma$ define-se recursivamente pelas seguintes regras:

- base Os conjuntos $\empty, \set{\nil}$ e, para cada $a \in \Sigma,\ \set{a}$ são linguagens regulares.

- passo Se $A$ e $B$ forem linguagens regulares então $A\cup B, AB, \cl{A}$ também são linguagens regulares.

- fecho Um conjunto de palavras é uma linguagem regular se, e só se, pode ser definido através de um número finito de aplicações do passo a partir dos conjuntos da base.

Alguns exemplos de linguagens regulares:

- $\set{\tt 001, 110} = \set{\tt 0}\set{\tt 0}\set{\tt 1} \cup \set{\tt 1}\set{\tt 1}\set{\tt 0}$.

- Qualquer linguagem finita.

- O conjunto das palavras que começam em $\tt 0$ é infinito mas regular: $\set{\tt 0}\cl{\set{\tt 0, 1}}$.

Expressões Regulares

A notação usual dos conjuntos, com $\set{}, \del{}$, etc. torna difícil escrever e ler linguagens regulares. Para aliviar esse problema usa-se uma notação específica.

Expressão Regular (ER). Seja $\Sigma$ um alfabeto. Uma expressão regular sobre $\Sigma$ define-se recursivamente pelas seguintes regras:

- base As expressões vazio $\empty$, palavra vazia $\nil$ e, para cada $a \in \Sigma,\ a$ são expressões regulares.

- passo Se $a$ e $b$ forem expressões regulares então a união $a \cup b$, a concatenação (ou produto) $a\cdot b$ e a iteração $\cl{a}$ também são expressões regulares.

- fecho Uma expressão é uma expressão regular se, e só se, pode ser definida através de um número finito de aplicações do passo a partir das expressões da base.

Alguns exemplos de expressões regulares:

- $001\cup 110 \simeq (0 \cdot (0 \cdot 1)) \cup ((1\cdot 1) \cdot 0)$.

- Qualquer palavra de $\cl{\Sigma}$.

- $0 \cdot \cl{(0 \cup1)}$.

Antes de avançar no estudo das ER e LR é importante esclarecer o seguinte ponto importante sobre a notação das expressões regulares:

Regras de Simplificação das Expressões Regulares. A escrita completa de uma expressão regular pode (ainda) ser confusa, por causa dos parêntesis:

$$ (\cl{0} \cup (1 \cdot 0 \cdot (\cl{0}))) \cdot 1 \cdot (\cl{0}) \cdot (((0 \cdot (\cl{1}) \cup (\cl{1})))) $$

Para simplificar esta escrita usam-se as seguintes regras de simplificação:

- Sempre que possível não se usa o símbolo da concatenação. Isto é, em vez de $x \cdot y$ escreve-se $xy$.

- A iteração $\cl{}$ tem precedência sobre $\cdot$ e sobre $\cup$. Isto é, $0\cdot \cl{1}$ é $0\cdot (\cl{1})$, não $\cl{(0\cdot 1)}$. Igualmente,$0\cup \cl{1}$ é $0\cup (\cl{1})$, não $\cl{(0\cup 1)}$.

- A concatenação $\cdot$ tem precedência sobre a união $\cup$. Isto é, $a\cup b\cdot c$ é $a \cup (b \cdot c)$, não $(a \cup b) \cdot c$.

Com estas regras a ER acima fica com o seguinte aspeto: $$ (\cl{0}\cup 10\cl{0})1\cl{0}(0\cl{1}\cup\cl{1}) $$

Diagramas das Expressões Regulares

As expressões regulares podem ser representadas por um diagrama gráfico cuja visualização pode ajudar a entender a sua estrutura.

Diagrama de uma Expressão Regular (Diagrama de Wirth). O diagrama de uma expressão regular é um grafo orientado definido para as operações base e passo da seguinte forma:

Forma da Expressão Regular Tipo Sub-Grafo $a$ símbolo ou $\lambda$ $xy$ concatenação $x\cup y$ união $\cl{x}$ iteração

Por exemplo, o diagrama da expressão regular $\cl{(11 \cup 0)}\cl{(00 \cup 1)}$ pode ser obtido da seguinte forma:

| Operação | Diagrama |

|---|---|

| Início |  |

| Concatenação |  |

| Iterações |  |

| Uniões |  |

No diagrama final há várias arestas que podem ser eliminadas e ainda continuar a representar a expressão regular inicial. Por exemplo, uma das duas arestas $\nil$ consecutivas, no cento do diagrama, pode ser eliminada.

| Operação | Diagrama |

|---|---|

| Simplificação |  |

Neste caso foi simples detetar uma aresta que podia ser eliminada. Em geral, quais são as arestas que podem ser eliminadas?

Teorema da Eliminação de Arestas Vazias. A aresta

pode ser eliminada se:

- O vértice $\alpha$ não é final e não saem mais arestas de $\alpha$ ou

- O vértice $\beta$ não é inicial e não entram mais arestas em $\beta$.

Alternativamente, a aresta não pode ser eliminada se:

- O vértice $\alpha$ é final ou saem mais arestas de $\alpha$ e

- O vértice $\beta$ é inicial ou entram mais arestas em $\beta$.

Usando o teorema da eliminação de arestas vazias:

| Operação | Diagrama |

|---|---|

| Simplificação (II) |  |

Semântica das Expressões Regulares

O número quatro pode ser referido de várias formas: IV, 100, 4, quatro, 2+2, etc. Todas essas formas são expressões – texto, sintaxe – cuja interpretação – significado, semântica – é um certo objeto abstrato.

Esta é também a relação entre as linguagens regulares e as expressões regulares: As linguagens são conjuntos (objetos matemáticos, abstratos) que podem ser representados por certas expressões. Isto é, a semântica das ER são as LR. Reciprocamente, as ER são uma sintaxe para as LR. Mais precisamente:

Linguagem Representada por uma Expressão Regular. Qualquer expressão regular sobre $\Sigma$ representa uma certa linguagem, definida pelas seguintes regras:

- $L(\empty) = \empty$.

- $L(\nil) = \set{\nil}$.

- Para cada $a \in \Sigma, L(a) = \set{a}$.

- Se $x$ for uma expressão regular então $L(\cl{x}) = \cl{L(x)}$.

- Se $x, y$ forem expressões regulares então $L(x \cup y) = L(x) \cup L(y)$.

- Se $x, y$ forem expressões regulares então $L(xy) = L(x) L(y)$.

Até aqui, e neste enunciado em particular, estão a ser usados os mesmos símbolos (sintaxe), por exemplo $\empty, \cup, \cl{}$ com significados (semântica) muito diferentes. Por exemplo, “$\cup$” numa ER é apenas um símbolo que liga outras ERs — da mesma forma que + liga \quaddois números\quad duas expressões numéricas. Mas “$\cup$” numa LR é uma operação entre conjuntos, que tem um valor bem definido — tal como 2 + 2 tem um valor bem definido (sob as convenções comuns).

Além disso, foi apenas definida uma função entre ERs e certos conjuntos de palavras – nada afirma, até aqui, que $L(x)$ é regular. Isto é, se $x$ for uma expressão regular então $L(x)$ é uma linguagem. A relação com as linguagens regulares fica esclarecida a seguir:

Equivalência de Expressões e Linguagens Regulares.

- Cada expressão regular representa uma linguagem regular. Mais especificamente: Se $x$ for uma expressão regular sobre $\Sigma$ então $L(x)$ é uma linguagem regular sobre $\Sigma$.

- Cada linguagem regular pode ser representada por uma expressão regular. Mais especificamente: Se $A$ for uma linguagem regular sobre $\Sigma$ então existe uma expressão regular sobre $\Sigma$, $x$, tal que $A = L(x)$.

Isto é, as expressões regulares denotam exatamente as linguagens regulares e a relação entre umas e outras é a função $L$. Dito de outra forma, as LR são a semântica associada às ER e, reciprocamente, as ER proporcionam uma sintaxe para as LR.

Por exemplo, a linguagem dos inteiros sem sinal e sem $0$ à esquerda (isto é, a representação binária dos números inteiros positivos):

$$ \begin{aligned} \set{0, 1, 10, 11, 100, 101, \ldots} &= \set{0} \cup \set{1}\set{\nil, 0, 1, 00, 01, \ldots} \cr &= \set{0} \cup \set{1}\cl{\set{0, 1}}\cr &= L(0 \cup 1\cl{(0 \cup 1)}) \end{aligned} $$

Há ainda outro tipo importante de equivalência: Depois de fixado o conjunto de símbolos e de operações, duas expressões (sintaxes) muito diferentes podem ter o mesmo valor (semântica).

Por exemplo o número quatro (o objeto matemático abstrato) pode ser representado pelas expressões $4$, $2+2$, $2^2$, etc. Nestes casos escreve-se $2+2 = 4$, $2^2 = 4$ etc. Mas em ALP é preciso cuidado com o sinal “$=$”. As expressões “$4$” e “$2+2$” são sintaticamente diferentes (por exemplo, porque “$4$” tem apenas um símbolo e “$2+2$” tem três) mas equivalentes (a mesma semântica).

Nas linguagens regulares “$A = B$” representa a igualdade entre conjuntos, uma relação matemática. No caso das expressões regulares é necessário esclarecer se se trata de igualdade sintática ou de uma equivalência (isto é, uma igualdade semântica). Por exemplo, $0 \cup 1$ e $1 \cup 0$ são diferentes ao nível sintático: diferem logo no primeiro símbolo. Mas ambas representam a mesma linguagem regular, o conjunto $\set{0, 1}$. Isto é, $L(0 \cup 1) = L(1 \cup 0)$.

Equivalência de Expressões Regulares. Duas expressões regulares, $x, y$, sobre $\Sigma$ são equivalentes, $x \equiv y$, se $L(x) = L(y)$.

No uso comum de expressões regulares pretende-se usar a equivalência, não a igualdade sintática, pelo que “$x = y$” normalmente representa a equivalência, apesar de esta escrita ser um abuso da notação. Isto é, escreve-se $0 \cup 1 = 1 \cup 0$ em vez de $0 \cup 1 \equiv 1 \cup 0$, porque é mais conveniente. Os casos em que se trata a igualdade sintática devem ser explicitamente assinalados como tais.

Propriedades das Expressões Regulares

Sejam $x, y, z$ expressões regulares sobre o alfabeto $\Sigma$. Considerando as operações de união e concatenação:

$$ \begin{aligned} x \cup (y \cup z) &= (x \cup y) \cup z & x(yz) &= (xy)z \cr x \cup \empty &= \empty \cup x = x & x\nil &= \nil x = x \cr && x\empty &= \empty x = \empty \cr x \cup y &= y \cup x \cr x \cup x &= x \cr x(y \cup x) &= xy \cup xz & (x \cup y)z &= xz \cup yz \end{aligned} $$

Para o fecho:

$$ \begin{aligned} \cl{\empty} &= \nil & \cl{\nil} &= \nil \cr \cl{\del{\cl{x}}} &= \cl{x} & \cl{x} &= \nil \cup x\cl{x} \cr x\cl{\del{yx}} &= \cl{\del{xy}} x \cr \cl{\del{x \cup y}} &= \cl{\del{\cl{x} \cup y}} \cr &= \cl{x}\cl{\del{x \cup y}} \cr &= \cl{\del{x \cup y\cl{x}}} \cr &= \cl{(\cl{x}\cl{y})} \cr &= \cl{(\cl{x}y)}\cl{x} \cr &= \cl{x}\cl{(y\cl{x})} \end{aligned} $$

Com estas equivalências uma ER inicialmente complicada (isto é, comprida e/ou profunda) pode ser simplificada. Um exemplo imediato é $\cl{(\cl{(\cl{a})})} = \cl{a}$. Outro exemplo:

$$ a\AST (b \cup (a\AST b\AST)\AST) \alert{a} a\AST (ba\AST)\AST \alert{b} \stackrel{?}{=} (a \cup b)\AST \alert{a}(a \cup b)\AST \alert{b} $$

Aplicando as regras de equivalência $$ \begin{aligned} &a\AST (b \cup \alert{(a\AST b\AST)\AST}) a a\AST (ba\AST)\AST b = & (x\AST y\AST)\AST = (x \cup y)\AST \cr &= a\AST \alert{(b \cup(a \cup b)\AST)} a a\AST (ba\AST)\AST b & y \cup (x \cup y)\AST = (x \cup y)\AST \text{(porquê?)} \cr &= \alert{a\AST (a \cup b)\AST} a a\AST (ba\AST)\AST b & x\AST (x \cup y)\AST = (x \cup y)\AST \cr &= (a \cup b)\AST a \alert{a\AST (ba\AST)\AST} b & x\AST (y x\AST)\AST = (x \cup y)\AST \cr &= (a \cup b)\AST a (a \cup b)\AST b & \text{aceitável… continuando:}\cr &\stackrel{?}{=} \alert{b\AST a} (b\cup a)\AST b \end{aligned} $$

$$ \begin{aligned} &= \alert{(a \cup b)\AST} a (a \cup b)\AST b & x \cup y = y \cup x \cr &= \alert{(b \cup a)\AST} a (a \cup b)\AST b & (x \cup y)\AST = x\AST (y x\AST)\AST \cr &= b\AST\alert{(ab\AST)\AST a} (a \cup b)\AST b & (xy)\AST x= x(yx)\AST \cr &= b\AST a(b\AST a)\AST \alert{(a \cup b)\AST} b & x \cup y = y \cup x \cr &= b\AST a(b\AST a)\AST \alert{(b \cup a)\AST} b & (x \cup y)\AST = (x\AST y)\AST x\AST \cr &= b\AST a\alert{(b\AST a)\AST (b \AST a)\AST} b\AST b & x\AST x\AST = x\AST \text{(porquê?)} \cr &= b\AST a\alert{(b\AST a)\AST b\AST} b & (x\AST y)\AST x\AST = (x \cup y)\AST \cr &= b\AST a (b\cup a)\AST b \end{aligned} $$

As linguagens e expressões regulares são o passo atual para resolver o Problema Principal de ALP (versão 1) – Determinar um sistema computável, eficiente e adequado para definir linguagens de programação.

Nesse sentido importa responder às seguintes questões:

- Dada uma linguagem regular $A$, como obter um sistema computável e eficiente para determinar se $p \in A$?

- As linguagens regulares são adequadas para definir todas as linguagens de programação? Por exemplo, será possível definir a sintaxe dos programas

PythonouJavausando apenas expressões regulares?

Estas questões são resolvidas no próximo capítulo, Autómatos Finitos, onde é definido e estudado um modelo abstrato de computador simples e como este se relaciona com as ER e LR.

Palavras, Linguagens e Expressões Regulares — Exercícios

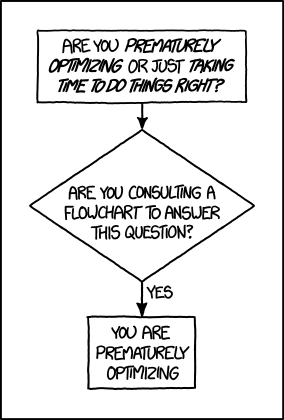

| Otimização Prematura |

|---|

|

| O xkcd obrigatório. |

Indicações gerais para os exercícios de implementação

Quase todos os exercícios de implementação descrevem uma função ou estrutura de dados sujeita a algumas condições. É da sua responsabilidade testar os casos suficientes para assegurar o comportamento esperado.

A linguagem de programação que usar é indiferente, desde que não dê tiros nos pés com opções aberrantes tipo “C” ou “COBOL”. Ou “JavaScript”. Principalmente “JavaScript”.

Também não é fundamental a maneira como organiza o código, seja em classes ou de outra forma, desde que o organize logicamente.

Mais alguns princípios gerais importantes:

- Os atributos das estruturas devem ter permissões tão restritas quanto possível. Se não for necessário alterar um atributo, não o permita. Se o atributo não tem de ser lido, esconda-o.

- DRY, Don’t Repeat Yourself, Não se repita. Se está a escrever código repetido está a fazer um disparate. Grande. Pare imediatamente e pense como vai evitar as repetições repetições.

- Premature optimization is the root of all evil, A otimização prematura é a raiz de todos os males. O seu código pode ser sempre melhorado: mais rápido, mais geral, mais específico, mais isto e aquilo. Se a melhoria não for necessária não perca tempo com ela.

- Use as ferramentas e adquira os conhecimentos do Engenheiro Informático que vai ser:

- Escolha e use ferramentas com boas comunidades e suporte. Torne-se fluente no seu ambiente de trabalho, na linha de comandos, no editor/ide, a usar repositórios, debuggers, testes, linters, profilers, etc.

- Se ainda não o fez, instale um sistema operativo no seu computador. Infelizmente, em geral, os computadores quando vêm da loja trazem instalada uma coisa que mal serve para utilizadores amadores. Instale e use um sistema operativo baseado em unix, como o linux, o bsd ou o macos.

- Este curso é de Engenharia Informática. Não permita que se confunda com uma qualquer “furmassão avançada de web-bonecos e insta-qualquer-coisa” daquelas que abundam nos motores de pesquisa — basicamente porque GIGO: Garbage In, Garbage Out.

- Invista tempo e esforço a identificar, compreender e resolver as dificuldades. Procure as melhores referências, fale com colegas e com professores — nada com valor é rápido ou fácil.

Os exercícios assinalados com “✓” serão resolvidos nas aulas práticas; Os assinalados com “†” têm elevada dificuldade. Todos os restantes devem ser resolvidos pelos alunos.

Alfabetos, Palavras e Linguagens

Exercício 01

- Defina alfabetos para:

- Escrever os números naturais $0, 1, 2, \ldots$ em notação hexadecimal.

- Representar a configuração de um semáforo, no que diz respeito aos automóveis.

- Escrever as palavras da língua portuguesa.

- Escrever frases em português.

- Seja $\Sigma = \set{0, 1, 2}$ um alfabeto, $u = 012$ e $v = 22021$ palavras sobre $\Sigma$. Escreva por extenso as seguintes palavras:

- $uv$

- $vu$

- $v^R$

- $u^3$

- $012^3$

- $(012)^3$

- $v^0u$

- $(v^2)^R$

Exercício 02

Liste todas as sub-palavras, todos o prefixos e todos os sufixos das seguintes palavras sobre o alfabeto $\Sigma=\set{0, 1, 2, 3}$:

- $01023$

- $11111$

- $\nil$

Exercício 03

Seja $\Sigma = \set{a, b}$. Construa definições recursivas dos seguintes conjuntos:

- $C_1 = \set{\text{palavras sobre } \Sigma \text{ tais que o símbolo } a \text{ ocorre aos pares}}$. $C_1$ inclui, por exemplo, $bbaab$ e $aaaa$ mas não inclui $aaa$ nem $aabaaaba$.

- $C_2 = \set{p \in \cl{\Sigma} \st \len{p} \text{ é par }, p \text{ começa por } a \text{ e, em }p\text{, os } a \text{ e os } b \text{ ocorrem alternados}}$.

- $C_3 = \set{p \in \cl{\Sigma} \st p\ \text{é capicua}}$.

- ✓ $C_4 = \set{a^nb^n \in \cl{\Sigma} \st n > 0}$.

- $C_5 = \set{a^ib^j \in \cl{\Sigma} \st 0 \leq i < j}$.

- ✓ $C_6 = \set{p \in \cl{\Sigma} \st \len{p}_a = \len{p}_b}$. Sugestão: Use a concatenação no passo recursivo.

Exercício 04

Encontre a menor palavra sobre o alfabeto $\Sigma = \set{0}$ que não está em $\set{\nil, 0, 0^2, 0^5}^3$.

Exercício 05

- † Demonstre as propriedades do fecho de linguagens.

- † Demonstre as propriedades da concatenação de expressões regulares.

Exercício 06

Na ordem lexicográfica, quantas palavras estão entre $0$ e $1$? E na ordem mista?

Exercício 07

Desenhe os diagramas das seguintes linguagens:

- $\set{0^n \st n\ \text{é par}}$.

- $\set{p \in \cl{\set{0, 1}} \st \len{p} \leq 4}$.

- $\set{0^n1^n \st n \geq 0}$.

- $\set{0^n1^m \st n, m \geq 0}$.

Exercício 08

Descreva recursivamente o conjunto das palavras sobre o alfabeto $\set{a, b}$…

- com número par de símbolos.

- com número par de ocorrências de $a$.

- com número par de ocorrências de $a$ e número ímpar de ocorrências de $b$.

- com número ímpar de símbolos ou com menos de $n$ símbolos.

- com número ímpar de símbolos ou com, pelo menos, $n$ símbolos.

- com número ímpar de símbolos e com menos de $n$ símbolos.

- com número ímpar de símbolos e com, pelo menos, $n$ símbolos.

- de comprimento menor do que $n$ e com numero par de ocorrências de $b$.

- formadas por um certo número de $a$, seguido de um único $b$, seguido do mesmo número de $a$.

Exercício 09

- Calcule $\set{0, 1}\set{1, 2}$ e compare com $\set{1, 2}\set{0, 1}$. Enuncie o que observou como uma propriedade geral das operações de linguagens.

- É verdade que $\len{AB} = \len{A}\len{B}$?

- Sejam $A = \set{ (01)^n \st n\geq 0}$ e $B = \set{01, 010}$. Calcule $AB$ e $ABA$.

- Verifique que $\cl{\set{0, 10}}$ é a linguagem das palavras binárias que não têm $11$ como subpalavra e que terminam em $0$.

- † Confirme que $A^+ = \cl{A}$ se e só se $\nil \in A$.

- † Confirme que $\del{AB}^R = B^R A^R$ e que $\del{A \cup B}^R = A^R \cup B^R$.

Exercício 10

Mostre que, se $A, B$ forem linguagens então $\clpar{A \cup B} = \cl{A} \clpar{B\cl{A}}$.

Lembre-se que para provar que dois conjuntos $X, Y$ são iguais tem de provar as duas inclusões $X \subseteq Y$ e $Y \subseteq X$.

Exercício 11

Sejam $A = \set{\tt anti, pro, \nil}, B=\set{\tt pesso, soci}, C= \set{\tt al}$. O que são $ABC$ e $\cl{A}BC$?

Exercício 12

† Seja $A$ uma linguagem sobre $\set{0, 1}$ e $p \in \cl{\set{0, 1}}$. Encontre condições necessária e suficientes para que se verifique $\cl{A}\setminus\set{x} = A^+$.

Exercício 13

Verifique, com demonstrações ou contra-exemplos, quais das seguintes igualdades são válidas para todas as linguagens:

- $\clpar{A^R} = \del{\cl{A}}^R$.

- $\clpar{A^+} = \cl{A}$.

- $\clpar{A\cup A^R} = \cl{A} \cup \del{\cl{A}}^R$.

- $A^2 \cup B^2 = \del{A\cup B}^2$.

- $\cl{A} \cap \cl{B} = \clpar{A\cap B}$.

Exercício 14

Mostre que para $n \geq 1$:

- $\bigcup_{i=0}^n A^i = \del{\set{\nil} \cup A}^n$.

- $\del{\cl{A}}^n = \cl{A}$.

- Se $\nil \not\in A$ então $\del{A^+} = A^n \cl{A}$.

Exercício 15

Demonstre as seguintes igualdades:

- $A\clpar{BA} = \clpar{AB}A$.

- $\clpar{A \cup B} = \clpar{\cl{A}\cl{B}}$.

- $A\del{B\cup C} = AB \cup AC$.

- $\del{A \cup B}C =AC \cup BC$.

- $\cl{A}B\clpar{D\cl{A}B\cup C} = \clpar{A \cup B\cl{C}D}B\cl{C}$.

Expressões Regulares

Exercício 16

✓ Considere a expressão regular $\clpar{11 \cup 0}\clpar{00 \cup 1}$ e o respetivo diagrama.

- Encontre uma palavra incompatível com esta expressão regular.

- O que acontece se remover a aresta $\nil$ central do diagrama simplificado?

Exercício 17

- Desenhe e simplifique o diagrama de $\cl{a}b\clpar{c \cup d\cl{a}}$.

- Encontre a mais curta palavra não vazia das linguagens das seguintes expressões:

- $10\cup \del{0 \cup 11}\cl{0}1$.

- $\clpar{00 \cup 11 \cup \del{01 \cup 10}\clpar{00 \cup 11}\del{01 \cup 10}}$.

- $\clpar{\clpar{00 \cup 11} \cup \clpar{001 \cup 110}}$.

- Defina informalmente um algoritmo para encontrar a menor palavra numa linguagem regular definida por:

- Uma expressão regular.

- O diagrama de uma expressão regular.

Exercício 18

-

Desenhe os diagramas das seguintes expressões regulares:

- $\del{00 \cup 10}\clpar{101}\cup 01$.

- $\clpar{\clpar{00 \cup 11} \cup \clpar{001 \cup 110}}$.

- $\clpar{a \cup b\cl{c}d}b\cl{c}$.

-

Determine as expressões regulares definidas pelos seguintes diagramas:

-

Determine o menor diagrama que representa $\nil$.

-

Encontre exemplos que mostram a necessidade de cada uma das condições do teorema da remoção das arestas $\nil$.

Exercício 19

Construa uma expressão regular para representar os números reais sem sinal, de acordo com as seguintes regras:

- Um número real tem sempre uma vírgula decimal.

- Um número real começa por 0 se e só se a sua parte inteira é 0.

- Um número real termina em 0 se e só se a sua parte decimal é 0.

Exercício 20

Encontre expressões regulares para representar as seguintes linguagens:

- ✓ A linguagem das palavras sobre $\set{a,b,c}$ em que todos os $a$’s precedem todos os $b$’s que, por sua vez, precedem todos os $c$’s (donde que todos os $a$’s precedem todos os $c$’s), podendo não haver nem $a$’s, nem $b$’s, nem $c$’s.

- ✓ A linguagem da alínea anterior sem a palavra vazia.

- As palavras sobre $\set{a,b,c}$ de comprimento inferior a 3.

- As palavras sobre $\set{a,b,c}$ que começam por $a$, acabam em $cc$ e têm exatamente dois $b$’s.

- A linguagem das palavras sobre $\set{a,b}$ que têm $aa$ e $bb$ como subpalavras.

- As palavras sobre $\set{a,b}$ de que $bba$ não é subpalavra.

- ✓ A linguagem das palavras sobre $\set{a,b}$ que não têm prefixo $aaa$.

- ✓ A linguagem das palavras sobre $\set{a,b}$ que não têm $aaa$ como subpalavra.

- As palavras sobre $\set{a,b}$ em que $ab$ não ocorre.

- As palavras sobre $\set{a,b}$ em que $ab$ ocorre.

- As palavras sobre $\set{a,b}$ em que $ab$ ocorre só uma vez.

Exercício 21

Descreva informalmente as linguagens representadas pelas seguintes expressões regulares:

- $(a \cup b \cup c)(a \cup b \cup c)\AST $.

- $(a \cup b)((a \cup b)(b \cup a))\AST $.

- $5 \cup (1 \cup 2 \cup \cdots \cup 9)(0 \cup 1 \cup \cdots \cup 9)\AST (0 \cup 5)$.

- $c\AST (a \cup b)(a \cup b \cup c)\AST $.

- $(a(b \cup c)\AST a \cup b \cup c)\AST $.

Exercício 22

Simplifique as seguintes expressões regulares:

- ✓ $\emptyset\AST \cup a\AST \cup b\AST (a \cup b)\AST $

- $aa\AST b \cup b$

- ✓ $b\AST (a \cup (b\AST a\AST )\AST )ab\AST (ab\AST )\AST b$

- † $(a\AST b)\AST \cup (b\AST a)\AST $

Exercício 23

Encontre uma expressão regular para as seguintes linguagens binárias:

- Que representam as potências de $4$.

- Com, pelo menos, uma ocorrência de $001$.

- † Que não têm $001$ como subpalavra.

- Com, quanto muito, uma ocorrência de $00$ e, quanto muito, uma ocorrência de $11$.

- Em que nenhum prefixo tem mais dois $0$s que $1$s nem mais dois $1$s que $0$s.

Exercício 24

Verifique as igualdades $$ \begin{aligned} \cl{0}\clpar{0 \cup 1} &= \clpar{0 \cup \cl{10}} \cr \del{10}^+\del{ \cl{0} \cl{1} \cup \cl{ 0}} &= \clpar{10} \cl{10^+ 1} \end{aligned} $$

Exercício 25

-

Descreva em linguagem natural as linguagens das seguintes expressões regulares:

- $\clpar{ \cl{0} \cl{1}} 0$.

- $\clpar{ \cl{0 1}} 0$.

- $\clpar{00 \cup 11 \cup \del{01 \cup 10}\clpar{00 \cup 11} \del{01 \cup 10}}$.

- $\cl{0} \cup \del{\cl{0} 1 \cup \cl{0} 11}\clpar{0^+ 1 \cup 0^+ 11} \cl{0}$.

-

Simplifique as seguintes expressões regulares:

- $\del{00}\AST 0 \cup \del{00\AST}$.

- $\del{0\cup 1}\del{\nil \cup 00}^+ \cup \del{0 \cup 1}$.

- $\del{0\cup \nil}0\AST 1$.

-

Mostre que $\del{0^2 \cup 0^3}\AST = \del{0^2 0\AST}\AST$.

Exercício 26

Defina expressões regulares para as linguagens binárias das palavras que:

- O quinto símbolo a contar da direita é $0$.

- Têm $000$ ou $111$ como subpalavra.

- Não têm $000$ nem $111$ como subpalavra.

- Não têm $010$ como subpalavra.

- Têm um número ímpar de $0$s.

- Têm um número par de ocorrências de $011$.

Exercício 27

Defina uma ER para as datas de acordo com a Norma ISO 8601. Considere só o caso YYYY-MM-DD:

- Permita que sejam representadas datas incorretas, como

2014-34-96. - Restrinja os valores para os meses e para os dias, mas permita ainda dias inconsistentes com o mês. Por exemplo,

2014-02-31. - Restrinja os valores para os dias de forma a serem consistentes com o mês, mas ignore o anos bissextos (isto é, assuma que fevereiro tem sempre 28 dias). Por exemplo

2004-02-29não é válida. - Trate dos anos bissextos.

Um ano bissexto é um ano múltiplo de 4 (por exemplo, 1948 é bissexto), exceto se também é múltiplo de 100 (por exemplo, 1900 não é bissexto) mas os múltiplos de 400 são sempre bissextos (por exemplo, 1600 é bissexto).

Implementação

Programa 00

Escreva uma função, listWords(fileName) que lê o ficheiro de texto fileName e produz a lista de palavras que ocorrem (sequencialmente) nesse ficheiro. Descarte os símbolos de pontuação e converta as letras para minúsculas. Sugestão: consulte a documentação de str e de string do python.

Programa 01

Escreva uma função, symbolsIn(word), que tem como entrada uma string e que devolve uma lista de símbolos. Assuma que, por omissão, os símbolos da string são separados por underscore (_) mas, opcionalmente, a função tem o argumento sep para usar um separador alternativo.

| Entrada | Resultado |

|---|---|

"a_b_color_b_a" | ["a", "b", "color", "b", "a"] |

"single" | ["single"] |

"" | [""] |

"_" | ["", ""] |

Programa 02

Escreva uma função, alphabetFor(word), que tem como argumento uma string e que devolve o menor alfabeto para gerar essa palavra. Assuma que, por omissão, os símbolos da string são separados por underscore (_) mas, opcionalmente, a função tem o argumento sep para usar um separador alternativo.

Note bem que no resultado não devem aparecer elementos repetidos.

| Entrada | Resultado (sep="_") | Resultado (sep="") |

|---|---|---|

"a_b_color_b_a" | ["a", "b", "color"] | ["a", "_", "b", "c", "o", "l", "r"] |

"single" | ["single"] | ["s", "i", "g", "l", "e"] |

"" | [] | [] |

"_" | [] | ["_"] |

Programa 03

Escreva uma função, generated(word, alphabet), em que word é uma string e alphabet uma lista de string e que determina se os símbolos de word estão todos em word (isto é, o resultado é booleano). Assuma que, por omissão, os símbolos da string são separados por underscore (_) mas, opcionalmente, a função tem o argumento sep para usar um separador alternativo.

Entrada word | Entrada alphabet | Resultado |

|---|---|---|

"a_b_color_b_a" | ["a", "b", "color"] | true |

"single" | ["single"] | true |

"" | [] | true |

Programa 04

Use uma biblioteca de expressões regulares (do python3, por exemplo) e escreva expressões para reconhecer palavras que:

- Começam pela letra

a; Não começam pela letraa; Terminam na letraa; Não terminam na letraa. - Têm pelo menos uma ocorrência de

a; Não têm ocorrências dea; O número de ocorrências deanão é 1; O número de ocorrências deaé exatamente 1. - Têm um

aou umb; Têm umae umb; Têm umae, mais à frente, umb. - Se têm um

aentão também têm umb; Se têm umaentão também têm umbque ocorre antes doa; Se têm umaentão também têm umbque ocorre depois doa; Se têm umaentão não têm umb.

O pressuposto geral nas bibliotecas de ER é que vai ser feita uma pesquisa de subpalavras. Isto é, a ER é usada como um padrão que vai “percorrer” uma palavra “maior” para detetar subpalavras compatíveis com a ER dada.

Não é esse o pressuposto neste capítulo, onde as ER definem “palavras inteiras”.

Programa 05

- Escreva uma função

countRE(expr, words)em queexpré uma das funções acima ewordsuma lista destringe que devolve o número de palavras emwordsaceites pela ER deexpr. - Repita este exercício para a função

filterRE(expr, words)que devolve a lista das palavras emwordsaceites porexpr. Re-escrevacountRE = len(filterRE). - Escreva o predicado

allRE(expr, words)para testar se todas as palavras dewordssão aceites porexpr. O mesmo paraanyRE(expr, words)para testar se alguma palavra é aceite.

Programa 06

- Use os comandos

greppara substituir a funçãofilteracima ewcpara substituirlen. - Aplique os filtros e contagens às palavras portuguesas com as ER dos exercícios anteriores.

- Quantas palavras têm

caldepois de umvsem que ocorra umono meio? Quais estão em comum combritish_english?

Na linha de comandos, em geral, tem a seguinte documentação sobre cada comando, aqui ilustrado com

grep:

grep -hougrep --help, um resumo curto das principais operações.man grep, uma “página” com uma descrição curta do comando e uma lista das operações (a.k.a cheat sheet).info grep, um “livro” com a descrição completa do comando e operações.

Programa 07

Se observar as contagens de palavras portuguesas (no ficheiro portuguese):

- Há 431114 palavras.

- Das quais 355762 com a letra

a - E 75352 em que

anão ocorre.

Use o grep e o wc para obter exatamente estes três números.

Autómatos Finitos

|

No capítulo anterior definiram-se as linguagens e expressões regulares com vista a resolver o Problema Principal de ALP (versão 1) – Determinar um sistema computável, eficiente e adequado para definir linguagens de programação. – onde:

- Computável: Existe um algoritmo que recebe como entrada uma palavra $p$ e ao fim de um número finito de passos produz uma resposta

simounãoconforme $p \in A$ ou não. - Eficiente: O número de passos referido no passo anterior não deve ser “muito maior” que o comprimento da palavra.

- Adequado: Deve ser possível definir (os programas de) qualquer linguagem de programação.

As linguagens regulares são uma classe de linguagens formais. Será que resolvem o Problema Principal de ALP? É necessário esclarecer:

- Como definir um algoritmo,

Super, que dada uma EReproduza um programaPL = Super(e)tal que, para cada palavrap, o resultadoPL(p)ésimounãoconformep in L(e)ou não? - Se as computações

Super(e)ePL(p)são eficientes? - Se as linguagens regulares são adequadas para definir (os programs de) qualquer linguagem de programação?

O programa

Supertem como entrada uma ERe, que especifica uma certa linguagem regular, e devolve um programaPL, que reconhece as palavras da linguagem definida pore.Isto é semelhante ao trabalho de um compilador. Por exemplo,

javacé um programa que tem como entrada ficheiros que especificam um certo programa e devolve esse programa em bytecode.

Autómatos Finitos Deterministas

Um modelo computacional simples, com memória limitada.

Introdução

| Exemplo de um Autómato Finito |

|---|

|

| O que acontece quando a entrada é $a\AST$? |

Para resolver o Problema Principal de ALP é necessário formalizar a noção de “computador/programa”, de forma a representar

PL = Super(e).

Os Autómatos Finitos são modelos formais de “computadores/programas” simples de descrever mas capazes de resolver vários problemas teóricos e com algumas aplicações práticas (ver o artigo na wikipedia).

Um autómato tem como entrada uma palavra que é processada símbolo a símbolo até que termina num certo estado. Em certos estados do autómato a palavra, depois de completamente “lida”, é aceite e noutros é rejeitada.

Um autómato pode ser representado por um grafo orientado. Os vértices “são” os estados do autómato e as “arestas” indicam como são “lidos” os símbolos.

Autómato Finito Determinista

Autómato Finito Determinista (AFD). Um Autómato Finito Determinista (AFD) ou Autómato de Estados Finitos (Em inglês: Determinist Finite State Machine (DFSM) ou Determinist Finite State Automaton (DFSA)) é um tuplo $\del{Q, \Sigma, \delta, q_I, F}$ onde:

- Estados de Controlo $Q$ é um conjunto finito.

- Alfabeto de Entrada $\Sigma$ é um alfabeto.

- Transição $\delta: Q \times \Sigma \to Q$ é uma função.

- Estado Inicial $q_I \in Q$.

- Estados Finais ou de Aceitação $F \subseteq Q$.

Intuitivamente, um AFD “anda” de estado em estado, conforme “processa” os símbolos de uma palavra, de acordo com a transição. Esse “passeio” começa no estado inicial e “consome” um símbolo da palavra de cada vez. Quando todos os símbolos estão processados, o AFD fica num certo estado. Se for um dos estados finais a palavra é aceite, caso contrário é rejeitada.

Por exemplo, seja $A = \del{\set{q_0, q_1, q_2, q_3}, \set{0, 1}, \delta, q_0, \set{q_1, q_2}}$ em que a transição $\delta$ é definida pela seguinte tabela: $$ \begin{array}{c|cc} \delta & 0 & 1 \cr \hline q_0 & q_1 & q_2 \cr q_1 & q_2 & q_3 \cr q_2 & q_2 & q_2 \cr q_3 & q_3 & q_3 \end{array} $$

- Os estados de controlo são os elementos de $Q = \set{q_0, q_1, q_2, q_3}$.

- O alfabeto de entrada é $\Sigma = \set{0, 1}$.

- A transição é a função $\delta(q,s) = q’$ em que $q’$ está na linha $q$ e coluna $s$ da tabela acima.

- O estado inicial é $q_I = q_0$.

- Os estados finais são os elementos de $F = \set{q_1, q_2}$.

A função de transição de um AFD é quase sempre representada por uma tabela como no exemplo acima. Mas por vezes é conveniente apresentá-la como um conjunto de triplos: $$\set{\del{i, a, j} \st j = \delta\at{i, a}, i \in Q, a \in \Sigma}.$$

A transição acima como um conjunto de triplos fica: $$\set{\del{q_0, 0, q_1}, \del{q_0, 1, q_2}, \del{q_1, 0, q_2}, \del{q_1, 1, q_3}, \ldots}$$

Configuração, Computação, Aceitação

A computação da palavra $p = 000$ por este autómato é a sequência $$q_0 \trf{0} q_1 \trf{0} q_2 \trf{0} q_2 \in F.$$

A notação $q \trf{a} q’$ indica que o autómato passa do estado $q$ para $q’$ lendo o símbolo $a$. Concatenado todos esses símbolos, da esquerda para a direita, obtém-se a palavra processada, neste caso $p = 000$. Também é indicado que o último estado é final, pelo que a palavra $p$ é aceite pelo autómato $A$.

Configuração. Computação. Palavra Aceite. Seja $A = \del{Q, \Sigma, \delta, q_I, F}$ um AFD.

Uma configuração de $A$ é um par $\del{q, s}\in Q \times \cl{\Sigma}$ onde $q$ é o estado atual e $s$ é o sufixo restante.

A computação da palavra $p = a_1 a_2 \ldots a_n \in \cl{\Sigma}$ pelo AFD $A$ é a sequência de configurações $$\del{q_0, a_1 a_2 \ldots a_n} \vdash_A \del{q_1, a_2 \ldots a_n} \vdash_A \cdots \vdash_A \del{q_n, \nil}$$ em que:

- base (configuração inicial) $q_0 = q_I$.

- passo (processamento do símbolo ativo) $q_i = \delta\del{q_{i-1}, a_i}, i \geq 1$.

Se $q_n\in F$ a palavra $p$ é aceite pelo autómato $A$. Caso contrário, $p$ é rejeitada por $A$.

Por exemplo, aplicando estas definições ao autómato anterior:

- De acordo com a base, a configuração inicial é $\del{q_0, \underline{0}00}$. O “símbolo ativo” está sublinhado.

- Aplicando o passo obtém-se a configuração $\del{q_1, \underline{0}0}$ porque $q_1 = \delta\del{q_0, 0}$.

- O passo é repetidamente aplicado, consumindo o símbolo ativo de cada vez, até que o sufixo restante é $\nil$:

- $\del{q_1, \underline{0}0} \vdash \del{q_2, \underline{0}}$.

- $\del{q_2, \underline{0}} \vdash \del{q_2, \nil}$.

A computação pode ser visualizada numa tabela, com uma configuração por linha

$$ \begin{array}{c|l} q & s \cr \hline q_0 & 000 \cr q_1 & 00 \cr q_2 & 0 \cr q_2 & \nil \end{array} $$ ou de forma ainda mais compacta: $$ \begin{array}{l} q_0 000 \cr q_1 00 \cr q_2 0 \cr q_2 \nil \end{array} $$ ou ainda $$ q_0 \trf{000} q_1 \trf{00} q_2 \trf{0} q_2 \in F. $$

A computação termina quando não é possível fazer mais transições. Neste exemplo o autómato fica no estado $q_2 \in F$. Portanto $p = 000$ é aceite por $A$.

O que acontece com $p=010$? A computação é a sequência: $$ q_0 \trf{010} q_1 \trf{10} q_3 \trf{0} q_3 \not\in F. $$

Neste caso a computação termina no estado $q_3 \not\in F$. Portanto $010$ é rejeitada por $A$.

Diagramas dos Autómatos Finitos Deterministas

Tal como com as expressões regulares, a visualização gráfica dos autómatos finitos deterministas é uma ferramenta útil.

Diagrama de um AFD. Seja $A = \del{Q, \Sigma, \delta, q_I, F}$ um AFD. O diagrama de $A$ é um grafo orientado em que:

- Os vértices são os estados de controlo $q\in Q$.

- Os arcos são definidos pela transição. Se $q’ = \delta\del{q, a}$ então o diagrama tem o arco

- O (único) vértice com o estado inicial é assinalado por um arco órfã a entrar:

- Os (vários) vértices com estados finais são assinalados por um círculo duplo:

Por exemplo, o AFD usado nos exemplos acima tem o seguinte diagrama:

| Diagrama de um AFD |

|---|

|

Transição Estendida

A transição de um AFD está definida para cada símbolo do alfabeto de entrada: $\delta: Q \times \Sigma \to Q$. No entanto é mais conveniente estender as transições a palavras: $\hat{\delta}: Q \times \cl{\Sigma} \to Q$.

Transição Estendida. Seja $A=\del{Q, \Sigma, \delta, q_I, F}$ um AFD. A função de transição estendida tem assinatura $\hat{\delta}: Q \times \alert{\cl{\Sigma}} \to Q$ e fica definida pelas seguintes regras recursivas:

- base - palavra vazia $\hat{\delta}\del{q, \nil} = q$.

- base - símbolos Para cada $a \in \Sigma, \hat{\delta}\del{q, a} = \delta\del{q, a}$.

- passo Se $p\in\cl{\Sigma}, a \in\Sigma$ então $\hat{\delta}\del{q, pa} = \delta\del{\hat{\delta}\del{q, p}, a}$.

Intuitivamente, $\hat{\delta}\del{q, p}$ é o estado em que o AFD fica depois de processar a palavra $p$ a partir do estado $q$.

Por exemplo, usando o AFD anterior: $$ \begin{aligned} \hat{\delta}\del{q_0, 000} &= \delta\del{\hat{\delta}\del{q_0, 00}, 0} \cr &= \delta\del{\delta\del{\hat{\delta}\del{q_0, 0}, 0}, 0} \cr &= \delta\del{\delta\del{\delta\del{q_0, 0}, 0}, 0} \cr &= \delta\del{\delta\del{q_1, 0}, 0} \cr &= \delta\del{q_2, 0} \cr &= q_2 \end{aligned} $$ e $$ \begin{aligned} \hat{\delta}\del{q_0, 010} &= \delta\del{\hat{\delta}\del{q_0, 01}, 0} \cr &= \delta\del{\delta\del{\hat{\delta}\del{q_0, 0}, 1}, 0} \cr &= \delta\del{\delta\del{\delta\del{q_0, 0}, 1}, 0} \cr &= \delta\del{\delta\del{q_1, 1}, 0} \cr &= \delta\del{q_3, 0} \cr &= q_3 \end{aligned} $$

Com transições estendidas a escrita de certas definições e condições fica mais compacta e intuitiva:

- Computação $\hat{\delta}\del{q, p} = q’ \Leftrightarrow \del{q, p} \alert{\vdash_A^{\ast}} \del{q’, \nil}$.

- Aceitação $p\in\cl{\Sigma}$ é aceite pelo AFD $A$ se, e só se $\hat{\delta}\del{q_I, p}\in F$. Se $\hat{\delta}\del{q_I, p} \not\in F$ então $p$ é rejeitada.

Linguagens Reconhecidas pelos AFD

É altura de começar a fazer a ligação entre as linguagens regulares e os AFD.

Linguagem Reconhecida por um AFD. Seja $A = \del{Q, \Sigma, \delta, q_I, F}$ um AFD.

A linguagem reconhecida (ou aceite) por $A$ é $$L\at{A} = \set{p \in \cl{\Sigma}\st \hat{\delta}\at{q_I, p} \in F}.$$

Dois AFD são equivalentes se aceitam a mesma linguagem.

Tal como com as expressões regulares, a definição de “equivalência” depende das linguagens associadas.

Conclusão

Nesta secção definiu-se um modelo de “computação” simples, os autómatos finitos deterministas e associou-se uma linguagem a cada AFD.

A intenção aqui é obter-se um modelo de computação das linguagens regulares. Portanto é preciso responder afirmativamente a estas duas questões:

- Qualquer linguagem regular é aceite por um AFD?

- Qualquer linguagem aceite por um AFD é regular?

Estas duas questões são tratadas na próxima secção.

Computação Não Determinista

Generalização dos autómatos deterministas.

Introdução

Com vista a obter-se um modelo de computação das linguagens regulares, estão por responder duas questões:

- Qualquer linguagem regular é aceite por um AFD?

- Qualquer linguagem aceite por um AFD é regular?

Formalmente, para responder a estas questões, mostra-se como obter um AFD “equivalente” a uma ER dada e, reciprocamente, como obter uma RE “equivalente” a um dado AFD.

Para construir estas equivalências é necessária estudar uma variante não determinista dos AFD.

Autómatos Finitos Não Deterministas

Nos AF deterministas há sempre exatamente uma transição para cada combinação $(q,a) \in Q \times \Sigma$. Isto é, no diagrama, de cada estado $q$ sai sempre exatamente uma aresta $a$, para cada $a \in \Sigma$.

| Diagrama de Um AFD. |

|---|

|

| De cada vértice sai exatamente uma aresta para cada símbolo. |

Para os diagramas das expressões regulares o caso é diferente:

- Algumas arestas “são” $\nil$.

- Não é necessário sair uma aresta para cada símbolo.

- Podem sair várias arestas com o mesmo símbolo.

Por exemplo, para a expressão regular $\clpar{11 \cup 0}\clpar{00 \cup 1}$ tem-se o diagrama

| Diagrama de uma ER. |

|---|

|

| Não se verificam as restrições dos AFD. |

Intuitivamente, as arestas dos AFD são caminhos obrigatórios enquanto que as arestas das RE são caminhos possíveis.

Os Autómatos Finitos Não Deterministas generalizam os AFD com todos os tipos de arestas das ER. Desta forma obtém-se um modelo computacional das ER que pode “correr” e ser analisado em termos de desempenho.

Autómato Finito Não Determinista (AFND). Um Autómato Finito Não Determinista (AFND) é um tuplo $A = \del{Q, \Sigma, \delta, q_I, F}$ em que

- Estados de Controlo $Q$ é um conjunto finito.

- Alfabeto de Entrada $\Sigma$ é um alfabeto.

- Transição $\alert{\delta: Q \times \del{\Sigma \cup \set{\nil}} \to \mathcal{P}\at{Q}}$ é uma função.

- Estado Inicial $q_I \in Q$.

- Estados Finais ou de Aceitação $F \subseteq Q$.

A diferença entre as definições de AFD e AFND está na assinatura da transição:

- A assinatura da transição dos AFD é $\delta: Q \times \Sigma \to Q$.

- Nos AFND acrescenta-se a palavra vazia $\nil$ a $\Sigma$. Desta forma, nos diagramas algumas arestas também podem ser $\nil$, além de $a\in\Sigma$.

- Em vez de $\delta\del{q, x}$ ser um único estado de controlo, nos AFND é um conjunto de possíveis estados, incluindo nenhum. Isto é, em vez de $\alert{\delta\del{q, x} \in Q}$, nos AFND $\alert{\delta\del{q, x}\subseteq Q}$.

É necessário replicar nos AFND o percurso feito com os AFD. Em particular, definir para os AFND o que é uma configuração, computação, palavra e linguagem aceite. Porém, é mais útil começar por definir o diagrama de um AFND.

Diagrama de um AFND. Seja $A = \del{Q, \Sigma, \delta, q_I, F}$ um AFND. O diagrama de $A$ define-se como no caso dos AFD, tendo em conta que algumas arestas podem ser $\nil$.

Por exemplo, dado o AFND com estado inicial $q_I = 0$, estados finais $F=\set{2}$ e transição $$ \begin{array}{c|ccc} q & 0 & 1 & \nil \cr \hline 0 & \empty & \set{0,\ 1} & \set{1} \cr 1 & \set{2} & \set{1,\ 2} & \empty \cr 2 & \set{2} & \empty & \set{1} \end{array} $$ o diagrama que se obtém é

| Exemplo de Diagrama de um AFND |

|---|

|

Note-se que:

- A tabela da transição tem uma coluna adicional, $\nil$.

- As “células” da tabela são subconjuntos de estados de controlo. Um valor possível é o conjunto vazio $\empty$.

- Neste primeiro exemplo os conjuntos foram denotados com $\set{\ldots}$ mas sempre que possível será usada uma notação mais compacta:

- Em vez de se escrever “$\set{0,\ 2}$” escreve-se apenas “$02$”, “$0\ 2$” ou “$0,2$” se a vírgula for mesmo necessária.

- O conjunto vazio é representado por nada: em vez de “$\empty$” escreve-se apenas “”.

- Os estados finais podem ser assinalados com o prefixo “$f$” e o estado inicial com um prefixo “$i$”. Se nada for indicado o estado inicial é sempre $q_0$ ou $0$ e dispensa-se a indicação de que é inicial.

De acordo com estas convenções a tabela da transição acima fica $$ \begin{array}{r|c|c|c} & 0 & 1 & \nil \cr \hline 0 & & 0\ 1 & 1 \cr 1 & 2 & 1\ 2 & \cr f2 & 2 & & 1 \end{array} $$ e define completamente o AFND $A$. Isto é, lendo a tabela determinam-se $Q, \Sigma, \delta, q_I, F$ todos os atributos que definem um AFND.

Tal como observado para os AFD, a função de transição de um AFND é quase sempre representada por uma tabela mas por vezes é conveniente apresentá-la como um conjunto de triplos: $$\set{\del{i, a, J} \st J = \delta\at{i, a}}.$$

A transição acima, como um conjunto de triplos, fica: $$\set{\del{0, 0, \empty}, \del{0, 1, \set{0, 1}}, \del{0, \nil, \set{1}}, \del{1, 0, \set{2}}, \del{1, 1, \set{1, 2}}, \del{1, \nil, \empty}, \ldots}$$

Observação: No caso dos AFD os triplos são $\del{i, a, j} \in Q \times \Sigma \times \alert{Q}$ e para os AFND os triplos são $\del{i, a, J} \in Q \times \Sigma \times \alert{\mathcal{P}\at{Q}}$. Enquanto que nos AFD $j \in Q$, nos AFND $J \subseteq Q$, podendo $J$ ser vazio, ter zero, um, dois, $n$ elementos de $Q$.

Configuração. Computação AFND. Seja $A = \del{Q, \Sigma, \delta, q_I, F}$ um AFND.

A definição de configuração como um par $\del{q, s} \in Q \times \cl{\Sigma}$ permanece igual ao caso dos AFD.

A computação da palavra $p = a_1 a_2 \ldots a_n \in \cl{\Sigma}$ pelo AFND $A$ é uma sequência de configurações $$\del{q_0, p_0} \vdash_A \del{q_1, p_1} \vdash_A \cdots \vdash_A \del{q_n, p_n}$$ em que:

- base (configuração inicial) $q_0 = q_I$ e $p_0 = p$.

- passo (processamento do símbolo ativo): $q_{i+1}\ \alert{\in}\ \delta\del{q_i, a}$ e $p_i = ap_{i+1}$.

- passo (transição vazia): $q_{i+1}\ \alert{\in}\ \delta\del{q_i, \alert{\nil}}$ e $p_i = p_{i+1}$.

- fim $p_n = \nil$ ou não há mais passos possíveis.

Ao contrário do que acontece com os AFD, nos AFND cada palavra pode ter mais do que uma computação possível.

Por exemplo, a palavra $01$ tem três computações possíveis:

- $0 \trf{\nil} 1 \trf{0} 2 \trf{\nil} 1 \trf{1} 1 \not\in F$: rejeita?

- $0 \trf{\nil} 1 \trf{0} 2 \trf{\nil} 1 \trf{1} 2 \in F$: aceita?

- $0 \trf{\nil} 1 \trf{0} 2 \trf{\nil} 1 \trf{1} 2 \trf{\nil} 1 \not\in F$: rejeita?

Esta situação, em que as computações de uma palavra podem terminar em vários estados, alguns finais e outros não, torna a definição de palavra aceite um pouco mais complicada do que para os AFD:

Palavra Aceite. Linguagem Reconhecida (AFND). Seja $A = \del{Q, \Sigma, \delta, q_I, F}$ um AFND.

Uma palavra $p\in \cl{\Sigma}$ é aceite por $A$ se existe alguma computação de $p$ por $A$ que termina num estado final $q \in F$ depois de terem sido lidos todos os símbolos de $p$. Isto é, se entre todas as computações de $p$ por $A$ alguma termina numa configuração $\del{q, \nil}$ com $q\in F$.

A linguagem reconhecida (ou aceite) por $A$ é o conjunto de todas as palavras aceites por $A$: $$L(A) = \set{p : \exists \del{q_I, p} \vdash_A^{\ast} \del{q, \nil}, q \in F}$$

Neste ponto a situação em relação ao Problema Principal de ALP é a seguinte :